Вештачка интелигенција већ је далеко од Р2-Д2. Ових би дана већина миленијала била изгубљена без паметних ГПС система. Роботи већ крећу по бојним пољима, а беспилотне летелице ускоро могу испоручивати Амазонове пакете на наше кућне прагове.

Сири може да реши компликоване једначине и каже вам како кувати пиринач. Чак је доказала да чак може одговорити на питања са смислом за хумор.

Али сви ови помаци зависе од корисника који даје смер АИ. Шта би се догодило ако ГПС јединице одлуче да не желе ићи на хемијске чистионице, или још горе, Сири је одлучила да може постати паметнија без вас?

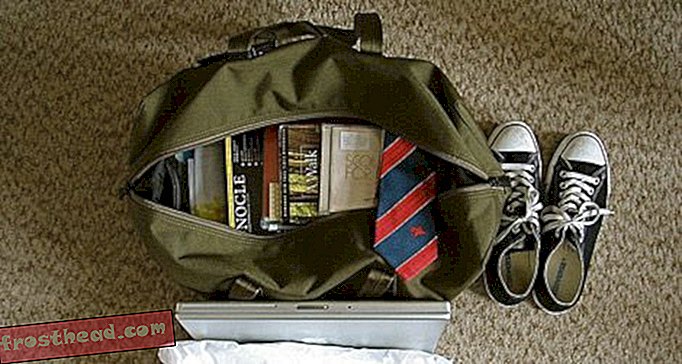

Наш коначни изум: вештачка интелигенција и крај људске ере. "> Наш коначни изум: Вештачка интелигенција и крај људске ере. ">" Пре него што делимо планету са супер-интелигентним машинама, морамо развити науку за њихово разумевање. У супротном, они ће преузети контролу ", каже аутор Јамес Баррат о својој новој књизи, Оур Финал Инвентион: Вештачка интелигенција и крај људске ере . (Љубазно од Јамеса Баррата)

Наш коначни изум: Вештачка интелигенција и крај људске ере. ">" Пре него што делимо планету са супер-интелигентним машинама, морамо развити науку за њихово разумевање. У супротном, они ће преузети контролу ", каже аутор Јамес Баррат о својој новој књизи, Оур Финал Инвентион: Вештачка интелигенција и крај људске ере . (Љубазно од Јамеса Баррата) Ово су само најмаснији исходи Јамес Баррат, аутор и филмски продуцент документарних филмова, прогнозира у својој новој књизи Оур Финал Инвентион: Умјетна интелигенција и крај људске ере .

Баррат, каже, вештачка интелигенција - од Сири до дронова и система за вађење података - престаће да тражи људе за надоградњу и самостално ће почети да тражи побољшања. А за разлику од Р2-Д2 и ХАЛ научне фантастике, АИ наше будућности неће нужно бити пријатељски, каже он: они би заправо могли бити оно што нас уништава.

Укратко, можете ли објаснити своју велику идеју?

У овом веку, научници ће створити машине са интелигенцијом која је једнака, а затим надмашује нашу. Али пре него што делимо планету са супер-интелигентним машинама, морамо развити науку за њихово разумевање. У супротном, они ће преузети контролу. И не, ово није научна фантастика.

Научници су већ створили машине које су у шаху бољи од људи, Јеопарди!, навигација, вађење података, претраживање, доказивање теорема и безброј других задатака. На крају ће се створити машине које су боље од људи у истраживању АИ

У том тренутку, они ће моћи да брзо побољшају своје сопствене могућности. Ове самопобољшавајуће се машине настављају циљевима са којима су створене, било да су у истраживању свемира, у игрању шаха или убирању залиха. Да би успели, они ће тражити и трошити ресурсе, било да су енергија или новац. Настојат ће да избјегну модусима квара, попут искључивања или искључења из мреже. Укратко, они ће развити погоне, укључујући самозаштиту и прибављање ресурса - погоне сличне нашем. Они неће оклевати да моле, позајмљују, краду и још горе да добију оно што им је потребно.

Како сте се заинтересовали за ову тему?

Ја сам документарац. 2000. године интервјуисао сам проналазача Раиа Курзвеила, роботичара Роднеиа Броокса и научно-фантастичну легенду Артхура Ц. Цларкеа за ТЛЦ филм о настанку романа и филма, 2001: Свемирска одисеја. Интервјуи су истраживали идеју Хал 9000 и злобних рачунара. Курзвеилове књиге приказале су АИ будућност као завидну „сингуларност“, период у којем технолошки напредак надмашује могућност људи да их разумеју. Ипак је предвидио само добре ствари које произилазе из АИ, а које су довољно јаке да одговарају и онда надмашују људску интелигенцију. Он предвиђа да ћемо моћи репрограмирати ћелије наших тела да поразе болест и старење. Развићемо супер издржљивост помоћу нано-ботова који испоручују више кисеоника него црвених крвних зрнаца. Напунићемо мозак компјутерским имплантатима тако да постанемо суперинтелигентни. А мозак ћемо преносити на трајнији медиј од нашег садашњег „софтвареа“ и заувек ћемо живети ако то желимо. Броокс је био оптимистичан, инсистирајући на томе да ће роботи са АИ бити савезници, а не претње.

Аутор с друге стране, Цларке, окренут научнику, био је песимистичан. Рекао ми је да ће интелигенција победити, а људи ће се вероватно надметати за опстанак са супер-интелигентним машинама. Није био специфичан у вези са оним што ће се догодити када делимо планету са супер интелигентним машинама, али осећао је да то не би победило за човечанство.

То је у супротности са свим што сам мислио о АИ, па сам започео интервју са стручњацима за вештачку интелигенцију.

Које доказе имате за потпору вашој идеји?

Напредна вештачка интелигенција је технологија двоструке употребе, попут нуклеарне фисије, која може да направи велику или велику штету. Тек почињемо увиђати штету.

До скандала са приватношћу НСА дошло је због тога што је НСА развила веома софистициране алате за вађење података. Агенција је искористила своје снаге да обруши метаподатке о милионима телефонских позива и целокупности Интернета - критички, сву е-пошту. Заведена снагом АИ за прикупљање података, агенција којој је повјерена заштита Устава умјесто тога је злоупотријебила. Развили су превише моћне алате да би их могли одговорно користити.

Данас се води још једна етичка битка око прављења потпуно аутономних беспилотних беспилотних летелица и роботских робота које покреће напредни АИ - убица људи без људи у петљи. Прави се између Министарства одбране и произвођача беспилотних летелица и робота које плаћа ДОД и људи који мисле да је глупо и неморално стварати интелигентне машине за убијање. Они који се залажу за аутономне беспилотне летелице и роботе на бојном пољу тврде да ће они бити моралнији - односно, мање емотивни, да ће циљати боље и бити дисциплинованији од људских оператора. Они против извлачења људи из петље гледају бедну историју беспилотних летелица убијања цивила и умешаност у ванзаконите атентате. Ко поставља моралну кривицу када робот убије? Произвођачи робота, корисници робота или нико? Никада не заборавите на техничке препреке да кажете пријатељу од непријатеља.

Дугорочно, како тврде стручњаци моје књиге , АИ који приступа интелигенцији на људском нивоу неће бити лако контролисати; нажалост, супер-интелигенција не подразумева доброхотност. Као што теоретичар АИ Елиезер Иудковски из МИРИ-ја (Институт за машинску интелигенцију) каже: „АИ вас не воли, нити вас мрзи, али ви сте направљени од атома, он може да користи за нешто друго.“ Ако етика не може бити уграђени у машину, тада ћемо стварати супер интелигентне психопате, бића без моралних компаса и дуго нећемо бити њихови господари.

Шта је ново у вашем размишљању?

Појединци и групе разноврсне попут америчког рачунарског научника Билл Јои-а и МИРИ-ја одавно упозоравају да се морамо много бојати од машина чија интелигенција помрачује нашу властиту. У нашој Финалној проналасци, тврдим да ће се АИ такође злоупотребити на развојном путу до интелигенције на нивоу човека. Између данашњег дана и дана када научници стварају интелигенцију на људском нивоу, имаћемо грешке у вези са АИ и кривичне пријаве.

Зашто није учињено више или шта се ради да се АИ не заустави на нас?

Нема једног разлога, али постоји много. Неки стручњаци не верују да смо довољно блиски за стварање вештачке интелигенције на нивоу човека и шире, да бисмо бринули о својим ризицима. Многи произвођачи АИ освајају уговоре са Агенцијом за напредне истраживачке пројекте у области одбране [ДАРПА] и не желе да покрећу питања која сматрају политичким. Предрасуда нормалности је когнитивна пристраност која спречава људе да реагују на катастрофе и катастрофе у настајању - то је дефинитивно део тога. Али пуно произвођача АИ нешто ради. Погледајте научнике који саветују МИРИ. И, много више ће се укључити кад опасности напредног АИ-ја уђу у главни дијалог.

Можете ли описати тренутак када сте знали да је ово велико?

Ми људи управљамо будућношћу не зато што смо најбржа или најјача створења на планети, већ зато што смо најпаметнији. Кад делимо планету са бићима паметнијима од нас самих, они ће усмерити будућност. Када сам разумео ову идеју, осетио сам да пишем о најважнијем питању нашег времена.

Сваки велики мислилац има претходнике чији је рад био пресудан за његово откриће. Ко вам је дао основу да изградите своју идеју?

Основе анализе ризика од АИ развио је математичар ИЈ Гоод, писац научне фантастике Вернор Винге, и други, укључујући програмер АИ Стеве Омохундро. Данас су МИРИ и Окфорд Институт за будућност човечанства готово сами у решавању овог проблема. Наша Коначна проналазак има око 30 страница крајњих белешки којима се признају ови мислиоци.

У истраживању и развоју ваше идеје, шта је била најважнија ствар? А тачка?

Најважније точке биле су писање Наша коначна проналазак и мој текући дијалог са произвођачима и теоретичарима АИ. Људи који програмирају АИ свесни су безбедносних проблема и желе да помогну у проналажењу заштитних мера. На пример, МИРИ ради на стварању „пријатељског“ АИ

Рачунарски научник и теоретичар Стеве Омохундро заговарао је приступ „скеле“, у којем доказано сигуран АИ помаже изградити нову генерацију АИ како би се осигурало да и она буде сигурна. Онда тај АИ чини исто, и тако даље. Мислим да би требало створити јавно-приватно партнерство да би се произвођачи АИ удружили да размењују идеје о безбедности - нешто налик Међународној агенцији за атомску енергију, али у партнерству са корпорацијама. Ниске тачке? Схватајући да ће се за креирање оружја користити најбоља, најнапреднија АИ технологија. И то оружје ће се на крају окренути против нас.

Које две или три особе највероватније покушавају да оповргну вашу аргументацију? Зашто?

Изумитељ Раи Курзвеил је главни извједник напредних технологија. У моја два интервјуа с њим, он је тврдио да ћемо се с АИ технологијама мешати путем когнитивних побољшања. Курзвеил и људи широко звани трансхуманисти и сингуларитари мисле да ће се АИ и на крају вештачка општа интелигенција и шире развијати код нас. На пример, рачунарски имплантати побољшаће брзину нашег мозга и свеукупне могућности. На крају ћемо развити технологију за транспорт наше интелигенције и свести у рачунаре. Тада ће супер-интелигенција бити бар делимично људска, што би у теорији осигурало да је супер-интелигенција „безбедна“.

Из многих разлога, нисам љубитељ ове тачке гледишта. Проблем је у томе што ми људи нисмо поуздано сигурни, а мало је вероватно да ће то бити и суперинтелигентни људи. Немамо појма шта се дешава са људском етиком након што се повећа њихова интелигенција. Имамо биолошку основу за агресију која недостаје машинама. Супер интелигенција би врло добро могла да буде мултипликатор агресије.

Ко ће највише утицати на ту идеју?

Сви на планети имају много страха од неуређеног развоја супер-интелигентних машина. Трка обавештајне службе тренутно траје. Постизање АГИ-ја је посао број један за Гоогле, ИБМ и многе мање компаније попут Вицариоус и Дееп Тхоугхт, као и ДАРПА, НСА и владе и компаније у иностранству. Профит је главна мотивација те трке. Замислите један вјероватни циљ: виртуални људски мозак по цијену рачунара. То би била најтрофејнија роба у историји. Замислите банке хиљада докумената са докторатом који раде 24 сата дневно на развоју фармацеутских производа, истраживању рака, развоју оружја и још много тога. Ко не би хтео да купи ту технологију?

У међувремену, 56 нација развија роботе на бојном пољу, а циљ је да их, и беспилотне летелице, постану аутономне. Биће машине које убијају, а не надгледају их људи. Осиромашене нације највише ће бити повређене од стране аутономних беспилотних летелица и робота. У почетку ће само богате земље моћи да приуште аутономне роботе за убијање, тако да ће богате нације држати ово оружје против људских војника из осиромашених народа.

Како би могао да промени живот онакав какав знамо?

Замислите: за само десет година, пола туцета компанија и нација преиспитују рачунаре који ривал или надмашују људску интелигенцију. Замислите шта се дешава када ти рачунари постану стручњак за програмирање паметних рачунара. Ускоро ћемо делити планету са машинама хиљадама или милионима пута интелигентнијим него што смо ми. И све време, свака генерација ове технологије биће наоружана. Нерегулисано, биће катастрофално.

Која питања остају без одговора?

Решења Очигледно решење било би дати машинама морални смисао због којег вреднују људски живот и имовину. Али, програмирање етике у машини испада изузетно тешко. Моралне норме се разликују од културе до културе, мењају се током времена и контекстуалне су. Ако се ми људи не можемо сложити када живот започне, како можемо рећи машини да штити живот? Да ли заиста желимо да будемо сигурни или заиста желимо бити слободни ? Можемо расправљати о томе цео дан и не постићи консензус, па како бисмо то евентуално могли програмирати?

Такође, као што сам раније напоменуо, морамо да повежемо АИ програмере. 1970-их истраживачи рекомбинантне ДНК одлучили су да обуставе истраживање и окупе се на конференцији у Асиломару у Пацифиц Гровеу у Калифорнији. Они су развили основне сигурносне протоколе попут „не прате ДНК на вашим ципелама“, због страха да ће контаминирати околину генетским делима у току. Због „Асиломар смерница“, свет има користи од генетски модификованих култура, а генска терапија изгледа обећавајуће. Колико знамо, избегнуте су несреће. Време је за Асиломар конференцију за АИ

Шта вам стоји на путу?

Огроман економски ветар подстиче развој напредне интелигенције АИ на нивоу човека по цени рачунара биће најбоља роба у историји. Гоогле и ИБМ неће желе да деле своје тајне са јавношћу или конкурентима. Министарство одбране не жели да отвори своје лабораторије за Кину и Израел, и обрнуто. Јавна свест мора да гура политику ка отворености и јавно-приватним партнерствима која су осмишљена да осигурају сигурност.

Шта је следеће за вас?

Ја сам продуцент документарног филма, тако да наравно размишљам о филмској верзији Нашег коначног изума .